(2018-06-12)約兩個月前,3,000名Google員工聯名寫信,抗議公司高層用機器學習軟體協助國防部發展AI,此「參戰」在內部一直沒有平息,而Google終於在日前宣布退出「戰區」。

(2018-06-12)本專欄四月份曾談到「AI能不能軍用?」,當時全球幾十名AI學者聯名呼籲AI不可以用在戰爭,然後又有三千名Google員工聯名寫信,抗議公司高層用機器學習軟體TensorFlow,協助國防部發展AI。Google參與的國防計畫叫Maven,目的在發展「電腦視覺」(Computer Vision),來精密解讀無人機追蹤目標拍攝的影像。

Google的「參戰」在內部一直沒有平息,在更多員工抗議、及部分員工憤而辭職之後,終於日前宣布退出「戰區」,以後不再用AI發展用在武器或傷害性的技術,至於已進行的Maven計畫,則於明年合約到期後退出,不再續約。

Google執行長Sundar Pichai為此宣布了七項發展AI的「倫理」,禁止發展自動化武器,但對非戰爭性的國防用途,仍保留彈性。下面就是這七項倫理規範:

- 公益:

AI 廣為運用在保健、安全、能源、交通、製造、娛樂各個領域,提供高品質的精準資訊,尊重使用所在地的文化、社會、法律的規範。 - 避免偏頗:

強調對影響到人的敏感特性,包括種族、性別、國籍、收入、性傾向、能力、政治與宗教信仰等,盡求公允。 - 安全:

加強安全考量,避免意外產生的危險與傷害,特定的AI技術會在封閉的環境測試,嚴密監視 。 - 對人負責:

AI系統會給人反饋、解釋、申訴的機會,AI技術也會由人來主導、控制。 - 隱私:

AI技術的發展與使用會遵照隱私原則,提供資料的透明與管制。 - 高標準:

技術創新源於科學方法,AI工具有潛力解開新的科學知識,會以高水準的卓越科學,來發展AI技術。 - 使用:

技術有多種功用,但會限制有潛在傷害或濫用的領域。

除了上面的規範,Google又提出負面不會發展的技術:

- 可能導致傷害整體的技術。

- 目的在傷人的武器或技術。

- 違反國際規範收集監視情報的技術。

- 違反一般國際法與人權的技術。

- 再一次表明不會發展用在武器上的AI,但會與政府及軍方在其他的領域合作,包括網路安全、訓練、軍事人力聘僱、軍人保健、搜尋與營救。

Google又提出長遠的AI目標,說要對股東負責,來提升領導力,並用嚴格的科學與多學科的方式,繼續分享所學到AI的技術。用這一原則發展未來的AI,與2004年公司創辦的價值一致,當初說過的價值,現在更相信是正確的方向。

現在的AI已轉向雲端,完整的神經網路架構,開放給人使用,用自己的資料訓練,發展自己的AI,變得越來越容易。Google、亞馬遜、微軟,是目前主要的AI雲端供應者,仍有蘋果等追趕在後,爭食這一龐大市場。

上世紀90年代關連式資料庫出現,大家都知道好用,但懂得運用的人卻很少。AI現在正面臨同一情況,大家都知道好處很多,但瞭解技術的人卻少,有人說全球有上千萬家企業或機構可以受益於AI,所以AI雲端的使用會越來越大眾化,得益於AI會越來越容易。

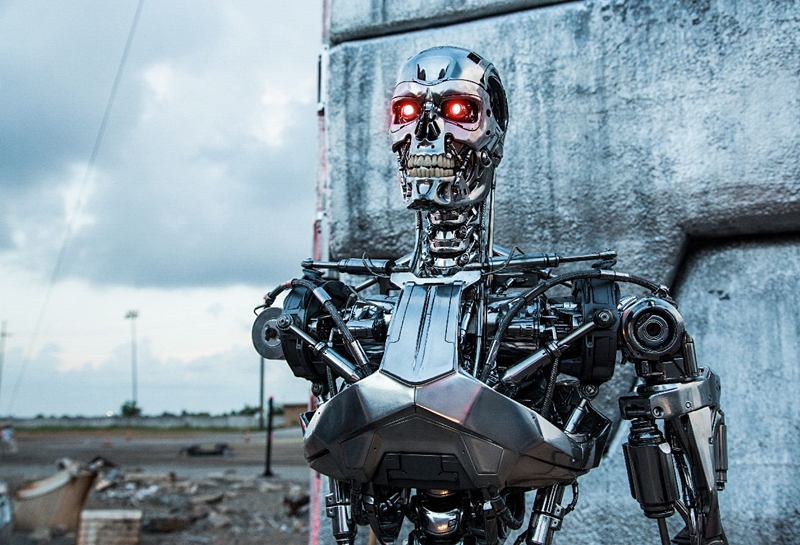

AI的軍用,可能讓大家立刻想到好萊塢電影「終結者」(Terminator),完全自主的武裝機器人任意肆虐,傳說有這方面的研究,但距成熟還遠。其實除了用在戰場,AI的軍事用途還很多,專家說主要可用在三個領域。

一是資料處理,如同一般的公司機構,有龐大的資料需用AI處理。二是加速,戰爭的速度越來越快,每一件事都要加快,AI會讓每一件事變快。三是協調,複雜的戰爭已無法單用人力協調,必須藉助AI。

但AI用在軍事總教人不太舒服,甚至恐懼,AI的技術公司遵守「倫理」規範,不去發展用在戰場上的AI,是不是就解除這一迷失,恐怕還沒那麼簡單。

AI的雲端提供了機器學習架構,使用的人可用來發展自己的AI,發展的結果是否仍能遵守規範,也許就難以約束了。AI不是武器,僅是能源,有了能源可以做的事就很多了。

軍用AI的需求龐大,除了軍方自行開發,借用民間技術在所難免。據報導,亞馬遜與微軟,正以億計的雲端計算標案,對像是五角大廈。

*本文取材自2018年6月11日「那福忠西海岸數位隨筆(53)」:Google宣示不發展戰爭AI

對本文有任何看法,歡迎 E-Mail:frank.na@gmail.com 與作者分享。

.jpeg)